News

-

Samsung、Galaxy AシリーズにAI体験を強化する新機能

Samsungは、同社のGalaxy Aシリーズのミッドレンジデバイスで、ユーザーが電源ボタンを長押しするだけでGoogleのGemini AIアシスタントを起動できる新機能を発表しました。

この新機能は、Galaxy A56、Galaxy A36、Galaxy A26に対応し、5月初旬に更新が予定されています。この機能は以前、Galaxy Sシリーズのフラッグシップモデルで確認されていました。

Samsung Electronicsのカスタマーエクスペリエンス部門の副社長であるJay Kim氏は、Googleとの協力について次のように述べています:

「SamsungとGoogleは、シームレスで直感的、かつ意味のあるAI体験を提供するために協力してきました。最新の技術をより多くのユーザーにアクセスできるようにすることを目指しています。Galaxy Aシリーズのユーザーが、Geminiをより速く、より自然に起動できるようになり、日常生活に賢いサポートをシームレスに取り入れることができることに、私たちは非常に興奮しています。」

>>>JPdenchi.comでは、ビジネスやプロフェッショナルのニーズに最適なバッテリーを入手できます。バッテリーに関するあらゆるニーズについては、今すぐお問い合わせください。

PR -

タイトル: Google フォトの新しい検索体験とクラシック検索モードへのショートカット

Google フォトの注目すべき特徴の一つは、その強力な検索機能ですが、最近のアップデートでは、同社のAIに焦点を当てた新しい検索体験が導入され、時にはフラストレーションを感じることがあります。この新しいAI駆動の検索機能は印象的である一方、日常的な使用においては遅く、実用的でないと感じることもあります。しかし、ユーザーがクラシック検索モードに迅速に戻るためのあまり知られていないショートカットがあります。

昨年、Google フォトは「Ask Photos」というAI強化検索機能を導入しました。この機能では、ユーザーが自然言語を使用してより複雑な質問をすることができます。従来の検索に比べて深い検索が可能ですが、同時に遅く、日常的な検索にはあまり実用的でないこともあります。

多くのユーザーが知らないかもしれませんが、Google フォトには、簡単にクラシック検索モードに切り替えるためのショートカットがあります。検索アイコンをダブルタップすると、インターフェースが「Ask」タブを表示していても、すぐにクラシック検索に移行できます。このショートカットは、多くのAndroidアプリで共通しており、専用の検索タブで検索ボックスが開かれることが多いですが、Google フォトでは特に便利です。なぜなら、最も頻繁に使用する検索モードに素早くアクセスできるからです。

残念ながら、このショートカットはiPhone版Google フォトでは動作しません。iOSでは、検索タブにいる場合にのみ検索ボックスが表示され、「Ask Photos」の検索がデフォルトで表示されるため、ショートカットがあまり実用的ではありません。

>>>JPdenchi.comでは、ビジネスやプロフェッショナルのニーズに最適なバッテリーを入手できます。バッテリーに関するあらゆるニーズについては、今すぐお問い合わせください。v

-

インテルの次世代GPUはプレミアムArcラインアップ向けにGDDR7メモリを採用する可能性がある

インテルのArc B580は昨年発売され、予算を重視するゲーマー向けの強力なグラフィックカードとして評価されました。しかし、インテルはさらに大きな野望を持ち、AMDやNvidiaと競り合うプレミアムGPU市場にも参入する計画です。Nvidiaは、現在GDDR7メモリを搭載した唯一の消費者向けGPUラインであるRTX 50シリーズで、このカテゴリーにおける高いハードルを設定しています。しかし、GDDR7は近い将来、インテルの次世代Arc GPUにも搭載される可能性があります。

インテルは最近、「メモリチューニングおよび認定」の役職のエンジニアを募集する求人情報を掲載しました。この求人情報によると、採用されたエンジニアは、インテルのArc製品におけるGDDR6およびGDDR7メモリの検証と特性評価を担当することになります。求人情報ではどのGPUラインがGDDR7を使用するかについて明示的には触れていませんが、インテルはまずそのメモリ規格を、NvidiaのRTX 50シリーズと競うために設計された最もプレミアムなCelestial GPUに導入する可能性が高いです。

>>>Sanyo KR4DH-4S 対応用 4000mAh Sanyo G1104S RG0296 RG02961高性能 互換バッテリー

GDDR7メモリは、1ピンあたり32Gbpsのデータ転送速度を誇り、最高のGDDR6速度(最大20Gbps)よりも60%高速です。さらに、GDDR7は消費電力が20%少なく、熱性能も向上しており、全体的なゲームパフォーマンスの向上に貢献する重要な進展です。したがって、インテルがこの最先端メモリを高性能なCelestial GPUに使用するのは理にかなっています。

インテルのタイムラインに関しては、Celestial GPUの公式な発売日についてはまだ発表されていませんが、噂によると、これらのGPUはXe3Pアーキテクチャを搭載し、これまでのArcシリーズとは異なり、TSMCで製造されない可能性があります。Celestial GPUの発売は2026年頃になると予想されていますが、インテルはまだ詳細を確認していません。その間、インテルはさらに多くのBattlemageバリエーションを発売するかもしれませんが、これらの発売日やデスクトップ向けかどうかについてはまだ情報が少ないです。

>>>Ridgid BSB14G 対応用 3000mAh Ridgid R83015 130252003 130254002 130254008高性能 互換バッテリー

インテルがGDDR7を採用することがプレミアムGPU市場に大きな影響を与える可能性がありますが、公式な発表を待って詳細が確認されるのを待つ必要があります。

>>>JPdenchi.comでは、ビジネスやプロフェッショナルのニーズに最適なバッテリーを入手できます。バッテリーに関するあらゆるニーズについては、今すぐお問い合わせください。

-

Google Playサービス、端末の自動再起動セキュリティ機能を導入予定

最近、最新のGoogle Playサービスのアップデートを詳しく調べたところ、端末が3日間連続でロックされている場合に自動的に再起動するセキュリティ機能が明らかになりました。しかし、Googleはこの機能がまだ実装されていないことを明言しており、現在はユーザーインターフェース(UI)が欠けているため、UIは今後のアップデートで追加される予定です。この機能は、提供されるようになるとオプトイン(手動で設定から有効にするの形式で利用可能となり、ユーザーが設定から手動で有効にする必要があります。

この機能が完全に機能するようになる時期はまだ不明ですが、早期に導入されることが予想されています。ちなみに、Appleは昨年iOS 18.1で類似の機能を導入しています。この機能はオプトイン形式で提供されるため、有効にしない選択をしたユーザーにはリスクはありません。

利用可能になると、この機能は、Android端末が72時間ロックされたまま未使用であると、自動的に再起動を行い、「初回解除前の状態」に戻します。この状態では、端末のデータが暗号化され、再起動後にパスコードを入力してアクセスする「初回解除後の状態」よりもアクセスが難しくなります。

>>>JPdenchi.comでは、ビジネスやプロフェッショナルのニーズに最適なバッテリーを入手できます。バッテリーに関するあらゆるニーズについては、今すぐお問い合わせください。

-

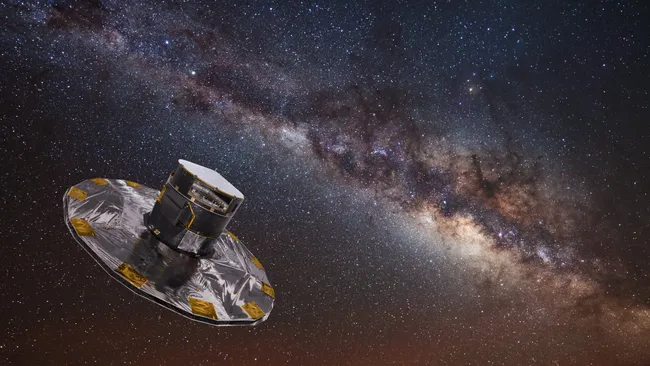

ガイア宇宙望遠鏡、11年の使命を終えて退役:銀河の見方を一変させた探査機

3月27日、科学者たちはガイア宇宙望遠鏡に別れを告げました。この日、11年間にわたり天の川銀河とその周辺の宇宙空間を詳細にマッピングしてきたミッションが幕を閉じました。ハッブルやジェイムズ・ウェッブほどの注目は集めなかったものの、ガイアは私たちの銀河に対する理解を根底から覆した存在です。

2013年に打ち上げられた欧州宇宙機関(ESA)のこの探査機は、これまでに約20億個の恒星、400万以上の銀河候補、約15万個の小惑星(中には衛星を持つものも)をカタログ化しました。

これまでにガイアのデータに基づいて発表された科学論文は13,000本以上にのぼり、今後もその数は大きく増加すると予想されています。プロジェクト科学者ヨハネス・ザールマン氏は「ガイアの広範なデータ公開は天文学のあらゆる分野に影響を与える宝の山です」と語りました。ガイアは当初の計画のほぼ2倍の期間にわたり稼働し、燃料切れの時点でESAは探査機を完全にシャットダウンしました。

>>>Huawei HB2770C7ECW 対応用 3575mAh Huawei MatePad Paper高性能 互換バッテリー

ガイアは地球から約160万キロ離れたラグランジュ点2(L2)に位置し、天の川銀河の最も正確な3D地図の作成を主な目的としていました。2つの望遠鏡と3つの科学機器を駆使し、恒星の位置、速度、色、組成を極めて高精度に測定。この前例のない地図により、銀河の渦巻構造の詳細や暗黒物質の分布、さらに銀河円盤がゆがみ、揺れているという証拠が明らかになりました。この現象は、おそらくいて座矮小銀河との衝突によるものと考えられています。

ガイアはまた、星の形成時期に関する常識を覆し、銀河円盤ではビッグバンからわずか10億年以内に星が誕生し始めていたことを示しました(従来は30億年後とされていた)。さらに、ラドクリフ波と呼ばれる全長約9,000光年におよぶ星形成領域や、星の表面に現れる微細な振動「スタークエイク(星震)」も多数検出。高速で移動する星、地球に比較的近いブラックホール、消え去った銀河の痕跡をたどる恒星の流れなども、ガイアがもたらした発見の一部です。宇宙膨張速度を巡る論争にもガイアの測定データが影響を与え、現在の宇宙論モデルに新たな疑問を投げかけています。

ESAは3月27日、残っていた推進剤を使ってガイアを廃棄軌道(グレイヴヤード軌道)に移し、今後のミッションに干渉しないように退役させました。さらに、ソーラーパネルが偶然に太陽光を受けても再起動しないよう、搭載ソフトウェアを意図的に破損させる措置も取りました。オペレーターのティアゴ・ノゲイラ氏は「長年ガイアを守ってきた冗長構造を一つ一つ解体していく退役戦略を設計しなければならなかった」と語りました。ミッションを記念して、1,500人の関係者の名前と個人的なメッセージ、詩が探査機のメモリに記録されました。

>>>Sanyo KR4DH-4S 対応用 4000mAh Sanyo G1104S RG0296 RG02961高性能 互換バッテリー

ガイアは沈黙しましたが、科学的な遺産はこれからが本番です。これまでに処理されたのは、収集データ全体の約3分の1にすぎません。ミッション終了時点でガイアは1ペタバイト以上の生データを記録しており、次のデータ公開は2026年、最終公開は2030年を予定しています。

ライデン大学のアンソニー・ブラウン氏はこう語っています。「ガイアはこの10年の“発見の機械”でした。そしてその流れは、これからも続いていくでしょう。」